2.3 Taxonomie pour le Web mining

La première utilisation du terme Web mining (WM) est attribuée à Oren Etzioni dans un article consacré à l’étude de l’applicabilité de la technologie du data mining sur le Web. Dans ce papier originel (Etzioni, 1996), il définit le Web mining comme étant l’application des techniques du data mining pour l’extraction d’informations pertinentes à partir des ressources disponibles dans le Web, une ressource Web peut être un document ou un service Web1.

1 La definition du W3C d’un service web est la suivante : “ a software application identified by a URI, whose interfaces and binding are capable of being defined, described and discovered by XML artifacts and supports direct interactions with other software applications using XML based messages via Internet-based protocols. ”, source : Semantic Web Enabled Composition of Web Services, PhD Dissertation Faculty of the Virginia Polytechnic Institute and State University, par Brahim Medjahed, 2004

Depuis 1996, plusieurs autres travaux et publications se sont intéressés au sujet. Dans la quasi-totalité de ces recherches, il est communément admis que le Web mining est un sujet au carrefour de nombreux autres domaines (recherche d’information, bases de données, intelligence artificielle…), qui a pour objectif d’étendre et d’adapter les techniques de la fouille de données afin de découvrir, puis d’analyser, des informations utiles (connaissances) à partir des données Web (Cooley et al., 1997), (Madria et al., 1999), (Kosala et al., 2000), (Stumme et al., 2006).

En fonction du type de données à fouiller, nous distinguons trois grandes classes ou catégories dans le Web mining (Madria et al., 1999), (Kosala et al., 2000) à savoir le Web content mining si nous considérons le contenu du Web, le Web structure mining si nous examinons sa structure et le Web usage mining si nous nous focalisons sur l’étude de l’usage du Web. Ces trois branches du Web mining seront étudiées plus en profondeur dans les sections suivantes.

2.3.1 Web content mining

Dans le Web Content Mining (WCM, en abrégé), traduit fouille de contenu du Web, nous nous intéressons à l’extraction d’informations utiles à partir des contenus du Web. Une partie dominante de ces contenus reste sous une forme textuelle, dans ce cas de figure des techniques du Text Mining sont largement utilisées, mais la fouille de contenu web englobe aussi tous les autres types de données disponibles tels que les données multimédia (images, audio, vidéo), les données symboliques, les métadonnées…etc.

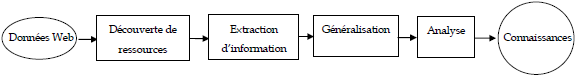

Le processus du WCM est apparenté et inclut donc le processus standard en Data Mining (Kosala et al., 2000). Selon (Etzioni, 1996), quatre tâches, illustrées dans la figure suivante tirée de (Pal et al., 2002), peuvent être distinguées dans ce processus.

2.3.1.1 Découverte de ressources

Dans la phase de découverte de ressources, on s’intéresse à la recherche automatique (une identification manuelle peut aussi être envisagée) de toutes les ressources pertinentes, en faisant recours au techniques issues du domaine de la recherche d’information.

Cette tâche se fond sur l’exploitation d’indexes (ensemble de paires : terme et adresse de ressource) construits automatiquement, dont les plus populaires sont ceux créés par les robots Web (appelés aussi spiders, agents, crawlers ou wanderers)1 tels que Altavista, WebCrawl…etc, en scrutant des millions de ressources Web et en stockant la collection des termes trouvés.

Puisque un robot Web pris séparément ne couvre généralement qu’une partie du Web, alors et afin de parer au problème de portée et ainsi améliorer la qualité des résultats, une deuxième technique utilisée ici est de se servir des métatcrawlers (ou meta-search engines). L’idée derrière les métacrawlers est d’assembler et d’exploiter les bases d’indexes de plusieurs robots sollicités en parallèle à l’aide d’une interface d’interrogation unifiée, puis de combiner et d’élaguer le résultat obtenu (Etzioni, 1996), (Joachims, 2002).

Les systèmes de découverte de ressources utilisent également les techniques de catégorisation automatique de texte dans le classement de documents Web. Cette technique facilite la création de répertoires thématiques et peut être utilisée pour filtrer les résultats de recherche (Etzioni, 1996), (Kosala et al., 2000), (Pal et al., 2002).

2.3.1.2 Extraction, sélection et prétraitement

La première tâche nous fournit un ensemble de ressources peu ou prou pertinentes. Dans cette seconde tâche nous nous occupons de l’extraction d’information à partir de ces ressources, c’est-à-dire de l’identification des fragments spécifiquement intéressants qui constituent le cœur d’un document Web.

Dans la majorité des cas d’extraction d’information, des programmes, appelés wrappers, codés manuellement sont utilisés afin de transformer les documents retrouvés en un

certain modèle de données (ensemble de termes, graphes,…etc)(Baldi et al., 2003). L’idéal serait de pouvoir développer des outils universels capables d’effectuer l’extraction d’information automatiquement et dynamiquement à partir de n’importe quelle ressource sur le Web. Cependant, le volume monstre et le dynamisme caractérisant le Web entravent cette direction, et des solutions générales scalables sont loin d’être maîtrisées. Ainsi, la plupart des outils développés se centrent sur des sites spécifiés et agissent sur des domaines prédéfinis (Etzioni, 1996).

1 Plus d’information sur les robots Web sur : http://www.robotstxt.org.

Cette tâche comprend, en outre, une série de transformations sur les informations extraites à partir des ressources localisées en vue de les préparer à la tâche de fouille qui succède. Des techniques courantes issues du domaine du traitement automatique des langues (TAL) sont appliquées, comme l’élimination des stopwords (termes fonctionnels ou vides) et le stemming (lemmmatisation) consistant à réduire les mots dérivés à leurs racines. Les items obtenus, peuvent éventuellement subir des transmutations en d’autres formes de représentations : listes de phrases, relationnelle, logique du 1ere ordre…etc. (Kosala et al., 2000).

2.3.1.3 Généralisation

La généralisation est la tâche de fouille proprement dite, où des techniques de data mining sont appliquées pour l’extraction de connaissances à partir des données précédemment préparées et modélisées (Kosala et al., 2000).

Eu égard a la taille hypertrophique du Web et le manque de données d’étiquetage de ses ressources, la classification des ressources Web est une des tâches les plus difficiles à mener. Comme nous l’avons mentionné dans le point 1.2.2.3, la classification est une tâche d’apprentissage supervisé, qui nécessite de disposer d’un nombre suffisant d’exemples représentatifs (positifs et négatifs) du problème considéré, chose non aisée à satisfaire pour les données du Web.

Ce problème peut être atténué en invitant l’utilisateur à juger les résultats générés par les procédures de classification, ceci par l’exploitation des informations de feedback qu’il retourne après une période d’apprentissage renforcé (Etzioni, 1996).

La segmentation quant à elle est, par contre, largement traitée dans le cadre du Web mining, car elle n’exige aucune autre information que la description des ressources.

Mais, elle implique un travail considérable dans l’interprétation de ses résultats. D’autres techniques de fouille sont aussi envisageables dans l’étape de généralisation telle que l’analyse d’association (Pal et al., 2002).

2.3.1.4 Analyse

La présence de l’être humain est primordiale dans tout processus de fouille. Dans le cadre du Web mining, elle se manifeste, grâce à l’interactivité qu’offre le Web, par le travail qu’effectue l’expert pour la validation et l’interprétation des résultats extraits à l’issue de la tâche de généralisation (Kosala et al., 2000),(Pal et al., 2002) .