Quels avantages pour les sociétés utilisatrices de logiciels libres?

1. Compatibilité (matérielle, protocoles, …)

Normes de programmation Son code source libre représente, de par sa définition, le noyau Linux et ne peut être utilisé à des fins propriétaires.

En effet, les termes de la GPL15 restent stricts dans ce domaine.

Une entité quelconque ne peut apporter des modifications au noyau Linux pour l’utiliser de manière externe sans en rendre le code source correspondant publiquement disponible.

Ces modifications réduisent à néant toute tentative de « détournement » du noyau pour en produire une variante propriétaire.

La communauté des utilisateurs et des développeurs n’a aucun intérêt à créer des normes spéciales et des protocoles propriétaires.

Ainsi le système d’exploitation intègre naturellement les standards industriels reconnus.

Nous pourrions penser que cette intégration n’est que pure théorie mais GNU/Linux est aujourd’hui un système d’exploitation compatible à la norme POSIX et ses sous-systèmes constitutifs demeurent en accord avec toutes les normes standards comme ANSI, ISO, ITEF et W3C.

Cependant, la demande de certification est une démarche séparée et non gratuite.

Un projet nommé « Linux Standard Base » a été créé et vise à unifier toutes les distributions selon le respect de quelques critères comme les emplacements des répertoires destinés aux fichiers système.

Il s’agit d’une sorte de charte que tout le monde peut télécharger et sur laquelle on peut méditer, réfléchir, mais aussi proposer des amendements.

L’aboutissement de ce projet est dans l’intérêt des utilisateurs puisqu’il conduira à la polyvalence et l’uniformisation de l’expérience des utilisateurs.

– Normes de réseaux et de protocoles

Linux n’est pas en reste en ce qui concerne les standards des protocoles pour les réseaux Internet, Intranet, etc.

En effet, Linux gère totalement les protocoles principaux et moins répandus (TCP/IPv4 mais aussi IPv6 depuis 1999, IPX/SPX, AppleTalk, X.25, Ethernet, Token Ring, fibre optique, frameRelay, ISDN et bien d’autres).

Cette prise en charge rend GNU/Linux semblable aux autres systèmes d’exploitation si nous le comparons au point de vue communication avec d’autres ordinateurs.

GNU/Linux est également capable de voir et modifier les fichiers Windows sur des partitions FAT32 ou NTFS (Windows est incapable de voir les partitions EXT2 et EXT3 de GNU/Linux).

14: www.networkcomputing.com/1224.fl.html

15: GPL = general public licence

16: www.pcmay.com/article/0,2997;>%253D

17: http://www.samag.com/articles/2001/017

18: http://www.sysadmin.mag.com

19:http://www.spec.org

20: http://www.cs.wisc.edu/bart/fuzz/fuzz.html

21: http://wwww.zdnet.fr

20: http://www.zdnet.fr

21: http://gnets.dhs.org/stories/bloor.php.

22: http://www.gnet.dhs.org/stories/bloor.Php3

23: http://wwww.syscontrol.ch/news/serversoftware.html

24: http://wwwjswum.com

25: www.cnet.com

– Normes de matériel

GNU/Linux est compatible avec quasi tous les processeurs existants.

Cette possibilité permet une meilleure uniformisation de l’ensemble des ordinateurs d’un réseau ou d’une entreprise.

En effet, les outils informatiques sont multiples et il est souvent frustrant de devoir choisir une seule architecture informatique comme uniformisation uniquement à cause du système d’exploitation ne reconnaissant pas les autres architectures.

Le problème a été résolu avec GNU/Linux.

En effet, GNU/Linux est capable de reconnaître les partitions et les ordinateurs distants quel que soit leur système d exploitation.

Avec le logiciel SAMBA, GNU/Linux peut se muter en serveur NetBIOS mais peut également être installé sur toutes les machines.

Si le système GNU/Linux satisfait un dirigeant d’entreprise, trouver une distribution GNU/Linux adaptée à l’architecture de n’importe quel ordinateur est totalement réalisable.

Cela va du processeur Motorola qui se trouve dans les PDA (Personal Digital Assistant) aux gros serveurs Sparc.

Les processeurs capables d’exécuter GNU/Linux sont: Intel x86 et Pentium, Motorola, Sparc et UltraSparc, Itanium, Alpha, ARM, les processeurs embarqués, les systèmes en temps réel mais aussi les AS/400.

2. Portabilité

Quelques considérations intéressantes au sujet de la portabilité, un terme simple mais avec des implications multiples:

- GNU/Linux et FreeBSD (deux systèmes d’exploitation libres couramment utilisés) supportent un éventail de plate-formes.

Beaucoup utilisent le terme « adaptabilité » pour répondre à la question: « Pouvez vous utiliser le même système de logiciels pour des petits mais aussi de grands projets? »

- Nombreux sont ceux qui voudraient commencer par un système modeste mais avec la possibilité d’accroître le système selon l’exigence des besoins sans modification onéreuse.

Sur ce point, les OSS/FS sont imbattables.

Vu que de nombreuses personnes peuvent rencontrer des problèmes d’adaptabilité, mais aussi vu que son code source peut être optimiser pour chaque plate-forme, l’adaptabilité de nombreux produits OSS/FS reste étonnante.

Observons spécifiquement le système GNU/Linux.

GNU/Linux fonctionne sur des PDA, sur du hardware désuet, sur du matériel PC moderne, sur une douzaine de chipsets différents, sur des mainframes, sur des clusters et sur un certain nombre de super ordinateurs.

GNU/Linux peut être utilisé pour le traitement parallèle massif: une approche commune pour ce traitement est l’architecture Beowulf.

Citons Sandia « Cplant » qui fonctionne sur un ensemble de systèmes exécutant GNU/Linux.

Il s’agit du quarantedeuxième ordinateur le plus performant au monde en juin 2001 (numéro 42 sur la liste PRINCIPALE de 500 ordinateurs géants, juin 200132).

Il existe également un prototype de mise en place de GNU/Linux sur une montre-bracelet.

Ainsi, il est possible d’acheter un petit système GNU/Linux et de l’accroître lorsque vos besoins augmentent.

En effet, vous pouvez remplacer le matériel, ou les processeurs par d’autres possédant une plus grande vitesse d’horloge, ou les architectures par d’autres très différentes au niveau CPU, et cela sans changer de système d’exploitation.

Les Windows CE/ME sont réduits à de petites plate formes et travaillent seulement sur les systèmes x86.

Beaucoup de systèmes Unix (tels que Solaris) s’adaptent bien à de grandes plate-formes spécifiques mais pas aussi bien aux petites plate-formes répandues.

Les systèmes OSS/FS font partie donc des programmes les plus adaptables.

3. Performance

Comparer les performances de GNU/Linux et de Microsoft Windows sur un matériel équivalent a souvent donné des résultats controversés parce que fondés sur différentes hypothèses.

Selon moi, les OSS/FS ont au moins prouvé qu’ils sont compétitifs et parfois leur supériorité dans de nombreuses circonstances.

Les comparaisons sur les performances dépendent des attentes et de l’environnement.

Ainsi la meilleure référence est celle que vous trouverez vous-même dans l’environnement de votre choix.

Si vous ne procédez pas de cette manière, vous chercher à utiliser des mesures objectives car il est aisé de créer des mesures faussées.

Voici tout d’abord quelques études récentes suggérant que certains systèmes OSS/FS battent leur concurrence propriétaire dans certaines circonstances:

- 1. L’article de PC magazine datant de novembre 2001: « Performance Tests: File Server Throughput and Response Times »16 a constaté que GNU/Linux et Samba surpassaient de manière significative Windows 2000 Server utilisé comme serveur de fichiers avec les protocoles réseau de Microsoft.

Cette constatation était valable indépendamment du nombre de clients simultanés (jusqu’à 30 clients testés), et cela se vérifiait sur l’ensemble des ordinateurs utilisés (Pentium II/233MHz avec 128 MB de RAM, Pentium III/550MHz avec 256 MB de RAM, et Pentium III/1GHz avec 512 MB de RAM, où MB signifie megabytes out 106 bytes 34).

En fait, plus les machines devenaient performantes plus la différence était prononcée.

Dans le cas du plus grand nombre de clients sur le matériel le plus rapide, le débit de GNU/Linux était d’environ 130 MB/sec contre les 78MB/sec de Windows (GNU/Linux était 78% plus rapide).

- 2. Au cours des tests de performance réalisés par le magazine Sys Admin, GNU/Linux bat Solaris (sur Intel), Windows 2000 et FreeBSD.

L’article « Which OS is Fastest for High-Performance Network Applications? »17 (de l’édition de juillet 2001 du magazine Sys Admin 18) a examiné des systèmes à rendement élevé et a constaté que GNU/Linux bat ses compétiteurs: Solaris (sur Intel), FreeBSD (un système OSS/FS), et Windows 2000.

Les testeurs ont intentionnellement exécuté les systèmes de façon non – optimisése si ce n’est qu’ils ont augmenté le nombre de connexions TCP/IP simultanées (qui sont nécessaires pour le test des applications à processus mulptiples et asynchrones).

Ils ont utilisé les dernières versions des systèmes d’exploitation ainsi que la même machine et ont enregistré les résultats (par système d’exploitation) de deux essais de performance différents.

Les développeurs de FreeBSD se sont plaints au sujet de ces essais notant que FreeBSD par défaut augmentait la fiabilité (pas la vitesse) et que n’importe qui ayant un besoin significatif de performance procéderait d’abord à des réglages.

Alors, Sys Admin refit des essais pour FreeBSD 19 après optimisation.

Un des changements opérés était de passer au support «asynchrone» rendant le système plus rapide (avec augmentation du risque de perte de données en cas de panne de courant).

Il s’agit du support par défaut dans GNU/Linux, et il est facile à changer dans FreeBSD. La modification est très petite et raisonnable.

Toutefois, d’autres changements ont été effectués.

Par exemple, 17 patches du noyau FreeBSD ont été découverts et compilés, puis ont été utilisés.

Les autres systèmes d’exploitation n’ont pas eu la chance d’être parfaitement paramétrés et donc, comparer des OS non optimisés à un FreeBSD optimisé ne conduit pas à des conclusions probantes.

Leur test « monde réel » a mesuré avec quelle rapidité de grandes quantités d’e-mail pourraient être envoyées en utilisant leur serveur d’envoi (MailEngine).

Aucune différence ne survenait jusqu’à 100 envois simultanés, mais à mesure que le nombre augmentait, les systèmes commencèrent à montrer des différences significatives dans leur cadence d’envoi d’e-mail.

GNU/Linux était nettement plus rapide que ses concurrents avec 500 envois simultanés, excepté FreeBSD optimisé.

FreeBSD optimisé avait des performances semblables à GNU/Linux pour l’exécution de 1000 envois simultanés ou moins.

Puis il réalise une pointe avoisinant 1000-1500 connexions simultanées, suivie d’une diminution constante (non subie par GNU/Linux) de sa performance relative.

FreeBSD optimisé a eu des problèmes au moment de dépasser les 3000 envois simultanés.

Avec 1500 envois simultanés, GNU/Linux envoyait 1,3 millions d’e-mail par heure tandis que Solaris en envoyait approximativement 1 million, Windows 2000 et FreeBSD non optimisé environ 0,9 millions.

- 3. GNU/Linux a produit avec TUX (Web serveur/accélérateur) de meilleures valeurs SPEC que Windows/IIS (Internet Information Server) dans de nombreux cas et cela même sur des configurations inférieures.

Le consortium SPEC38 est une organisation essayant de donner des « benchmarks » impartiaux.

Nous pouvons comparer Microsoft Windows et GNU/Linux au niveau des résultats SPECweb99 (qui mesurent les performances de serveurs Web) avec un matériel identique (les deux systèmes d’exploitation ayant subi la même quantité d’efforts d’optimisation de performance).

Malheureusement, les choses peuvent se compliquer: nous ne pouvons que rarement tester les deux systèmes d’exploitation avec le même équipement.

Ainsi, lors du test conduit le 13 juillet 2001, les configurations testées différaient, par exemple, en utilisant un nombre différent de disques durs ou en incluant quelques disques durs plus rapide.

En utilisant tous les résultats disponibles au 13 juillet 2001, il existait trois configurations de matériel, toutes de Dell [utilisant GNU/Linux (par emploi du Web server/accelerator TUX) et Windows (par emploi IIS)] sur un matériel de base identique.

Voici les résultats SPECweb99 en date du 13 juillet 2001, notant des différences de configuration:

La première ligne (le PowerEdge 4400/800) n’est pas vraiment probante.

Le système d’IIS présente des performances inférieures.

Mais, ce programme possède un contrôleur de réseau.

Alors que le système de TUX en a deux. Donc, ce système aurait présenté de meilleures performances en cas d’utilisation de deux connections réseau.

La deuxième ligne (le PowerEdge 6400/700) démontre que GNU/Linux additionné de TUX restent les plus performants.

Le système d’IIS était doté de deux disques durs supplémentaires (afin d’améliorer les performances du système).

Pourtant, le système TUX a réalisé des performances plus de deux fois supérieures à celles d’IIS.

La dernière ligne pour le PowerEdge 8450/700 reste bien plus complexe.

D’abord, les lecteurs des deux systèmes sont différents.

Ce qui devrait offrir à IIS le rendement le plus élevé vu que la vitesse de transfert est certainement plus importante.

Ainsi, la configuration GNU/Linux aditionnée du système TUX (bien que testée sur un matériel inférieur) a présenté de meilleures performances en certaines occasions.

Etant donné que d’autres facteurs peuvent être ajoutés, l’ensemble demeure difficile à juger.

Dans certaines situations, un meilleur matériel peut produire une performance moins satisfaisante si un autre facteur non enregistré a un effet significatif.

Si tout va bien à l’avenir, il y aura beaucoup d’essais sur de semblables configurations.

4. Fiabilité

Il existe plusieurs anecdotes sur la fiabilité des OSS/FS, mais finalement de nombreuses données la confirment.

- 1. Les applications équivalentes d’OSS/FS sont, selon une étude de 1995, plus fiables.

Le «Fuzz Revisited» de l’année 1995 20 a mesuré la fiabilité de ces systèmes en alimentant des programmes avec des caractères aléatoires et en déterminant lesquels ont résisté aux crashs.

De plus, il est également intéressant de comparer les résultats des tests des systèmes commerciaux aux résultats des tests des « freeware » GNU et de GNU/Linux.

Les sept systèmes commerciaux dans l’étude de 1995 présentent un pourcentage de panne de 23%, contre 9% pour GNU/Linux et 6% seulement pour les utilitaires de GNU.

- 2. GNU/Linux est plus fiable que Windows NT, selon une expérience de dix mois de Zdnet21.

ZDnet a mené un test de dix mois sur la fiabilité en comparant les systèmes Open Linux de Caldera, Red Hat Linux, et Windows NT Server 4.0 de Microsoft avec Service Pack 3.

Chaque système a utilisé un matériel (CPU unique) identique.

De plus, des requêtes réseau ont été envoyées en parallèle à chaque serveur pour des services Internet standard, des services d’impression, et des services d’archivage.

Le résultat fut que le serveur NT tomba en panne en moyenne une fois toutes les six semaines, chaque panne nécessitant environ 30 minutes de réparation.

Ce résultat n’est pas mauvais en soi, mais ni l’un ni l’autre des serveurs GNU/Linux ne s’est jamais planté.

Cet article de ZDnet réalise également un excellent travail en identifiant des faiblesses de GNU/Linux.

- 3. GNU/Linux semble aussi plus fiable que Windows NT selon une expérience annuelle de Bloor Research.

Bloor Research22 possédait les deux systèmes d’exploitation sur des machines Pentium relativement anciennes.

En l’espace d’un an, GNU/Linux ne tomba en panne qu’une seule fois en raison d’un défaut matériel (problèmes de disque), réparé en 4 heures, lui donnant une disponibilité mesurée de 99,95 pour cent.

Windows NT est tombé en panne 68 fois suite à des problèmes de matériel (disque), de mémoire (26 fois), de gestion de fichiers (8 fois), et d’un certain nombre de problèmes divers (33 fois).

Le total des réparations a atteint 65 heures et a donné une disponibilité de 99,26 pour cent.

Il est toutefois étrange que l’unique problème de GNU/Linux et un certain nombre de problèmes de Windows aient été dus à des problèmes matériels.

Nous pourrions penser à priori que le matériel utilisé pour tester Windows était plus mauvais, ou encore que GNU/Linux a fait un meilleur travail en évitant et en contenant les pannes de matériel.

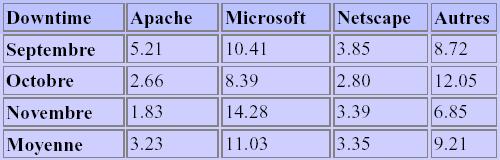

4. Selon une évaluation suisse portant sur trois mois, les sites utilisant le logiciel de serveur Web IIS de Microsoft passent plus du double de temps (en moyenne) offline que ceux utilisant Apache. Il s’agit des résultats de l’analyse 23 de Syscontrol AG à propos de l’uptime de sites web (annoncé le 7 février 2000) . L’étude fait état d’un test de plus de 100 sites Web suisses, pendant un trimestre, qui furent contrôlés depuis quatre emplacements différents toutes les cinq minutes.

Vous pouvez consulter leurs résultats et leurs conclusions en allemand 49.

Vous trouverez ci-dessous l’ensemble des données sous forme de durée moyenne en heures par mois de la panne (le temps pendant lequel le site était inaccessible), plus une moyenne sur trois mois:

Commentaire :

Il est difficile de ne pas remarquer qu’Apache (le web server OSS) a obtenu les meilleurs résultats sur une moyenne de trois mois (avec également de meilleurs résultats mensuels).

En effet, le mois le plus décevant d’Apache était meilleur que le mois le plus satisfaisant de Microsoft.

Selon moi, la différence entre Netscape et Apache n’est pas toujours significative statistiquement.

Toutefois, ceci nous permet de constater que la solution libre OSS/FS (Apache) possède une fiabilité au moins aussi bonne que la solution propriétaire la plus fiable.

- 5. Selon une étude de Netcraft, en date du 10 mars 2002, les OSS/FS se placent en bonne position dans le classement des 50 sites présentant le meilleur uptime.

90% de ces sites utilisent Apache et 82% sont exécutés sur les systèmes d’exploitation OSS/FS.

Netcraft conserve une trace des 50 sites les plus souvent demandés (avec les plus longs uptimes) à http://uptime.netcraft.com. En date du 10 mars 2002, on peut constater que 90% (45/50) des sites utilisaient le logiciel Apache.

Un serveur web de ce site était inconnu, les quatre autres n’utilisaient pas Apache.

Dans ces quatre n’utilisant pas Apache, aucun n’utilisait Microsoft IIS.

82% (41/50) fonctionnaient sur un système d’exploitation Open Source et les meilleurs uptimes n’étaient obtenus qu’avec des systèmes d’exploitation à base Unix (Aucun système Windows n’a été repris parmi les meilleurs uptimes).

5. Sécurité

Mesurer de manière quantitative la sécurité est malaisé. Cependant, en voici quelques tentatives. Celles-ci suggèrent que les OSS/FS demeurent souvent supérieurs aux systèmes propriétaires.

Concentrons-nous en particulier sur la comparaison entre les OSS/FS et les systèmes Windows.

- 1. L’assurance contre les « crackers » de J.S. Wurzler Underwriting Managers24 coûte 5 à 15% de plus en cas d’utilisation de Windows au lieu d’Unix ou de GNU/Linux pour Internet.

Au moins une compagnie d’assurance a indiqué que Windows NT semble moins sécurisé que des systèmes Unix ou GNU/Linux, cela résultant en des primes plus élevées pour les systèmes basés sur Windows.

Il est souvent difficile de découvrir quand une compagnie a été infiltrée avec succès.

Les compagnies ne désirent souvent pas divulguer une telle information au public pour diverses raisons.

En effet, si les consommateurs ou les associés perdaient la confiance en une compagnie, la perte résultante pourrait être bien plus importante que celle due à l’attaque initiale.

Néanmoins, les compagnies d’assurance assurant contre l’infiltration de crackers sont en droit de réclamer l’obtention de telles informations (comme un état d’assurance) et peuvent calculer de futures primes sur base de cette connaissance.

Selon CNET25, J.S. Wurzler Underwriting Managers a été un des premiers courtiers à avoir proposé une assurance contre les crackers.

Walter Kopf, vice-président de cette société d’assurance, signale que « nous avons découvert que la possibilité d’une perte augmente en utilisant le système NT ».

Il déclara également que la décision se base sur les résultats de centaines d’évaluations de sécurité que la compagnie a réalisées auprès de ses clients PME pendant les 2 dernières années.

- 2. Une autre manière de considérer la sécurité est justement de regarder les systèmes d’exploitation employés par les sites Web attaqués et de comparer à leur part de marché.

Un « site attaqué » est un site dans lequel quelqu’un s’est introduit et dont le contenu a changé (habituellement d’une façon assez évidente vu que des modifications subtiles ne sont pas souvent enregistrées).

Il est souvent très difficile pour les victimes de cacher le fait qu’une personne a réussi à pirater leur système avec succès.

Historiquement, cette information a été collectée par Attrition.org.

Un résumé peut être trouvé dans article de James Middleton 26 avec les données réelles trouvées sur le site Web d’Attrition.org.

Les données d’Attrition.org ont prouvé que 59% des systèmes piratés avec succès pendant la période d’août 1999 à décembre 2000 tournaient sous Windows, 21% sous Linux, 8% sous Solaris et 6% sous d’autres OS.

Ainsi, les systèmes sous Windows ont été presque trois fois plus fréquemment attaqués que les systèmes sous GNU/Linux.

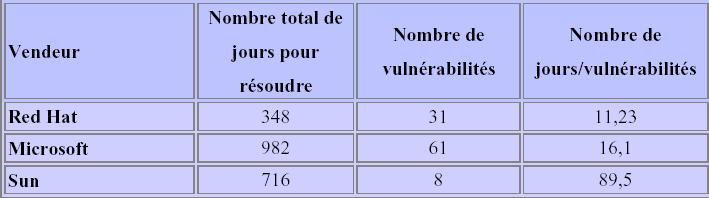

- 3. Un autre point de repères est une liste sur le site SecurityPortal 56 reprenant le temps que les constructeurs ont mis pour résoudre les vulnérabilités.

Voici Leur table des données pour 1999:

Des trois systèmes mentionnés, Solaris de Sun a présenté le moins de vulnérabilités, mais il fut celui qui a été le plus lent à répondre aux problèmes de sécurité.

Red Hat demeurait le plus rapide à résoudre les problèmes de sécurité et se plaçait en deuxième position parmi ces trois systèmes.

Il est intéressant de noter que le système d’exploitation d’Open BSD a eu moins de vulnérabilités enregistrées que les autres.

En résumé, avoir un système d’exploitation propriétaire ne signifie pas que vous êtes plus sécurisé.

- 4. IIS a été attaqué 1.400 fois plus fréquemment qu’Apache en 2001.

En outre, les ordinateurs sous « Windows Plus » (Windows avec l’extension Plus) ont été attaqués plus souvent que toutes les versions d’Unix.

Le co-fondateur et CEO de SecurityFocus, Arthur Wong, a réalisé une analyse des diverses vulnérabilités et attaques (basées sur des données de SecurityFocus) dans l’article de février 2002: « RSA: Security in 2002 worse than 2001, exec says » 27.

IIS a été attaqué à 17 millions de reprises, alors qu’Apache n’a été attaqué que 12.000 fois.

Il s’agit, certes, d’une comparaison choquante vu qu’il existe (sensiblement) plus de systèmes Apache que de IIS.

En l’an 2001, les systèmes Windows ont été attaqués 31 millions de fois tandis que certains systèmes d’Unix étaient attaqués 22 millions de fois.

[ … ] Pourquoi les Windows sont-ils vulnérables d’une façon si disproportionnée? Il existe trois raisons à cela, une sociale et deux techniques.

Windows est de loin la cible la plus attrayante pour des auteurs de virus simplement parce que son utilisation est largement répandue.

Pour propager un virus, celui-ci doit se transmettre à d’autres ordinateurs susceptibles de le recevoir.

En moyenne, chaque infection doit causer au moins une infection supplémentaire.

Le grand nombre de machines sous Windows permet d’arriver plus facilement à ce seuil.

Par ailleurs, Microsoft a fait un certain nombre de choix de conception au cours des années (par exemple l’exécution des macros de démarrage dans Word, l’exécution des pièces jointes dans Outlook, le manque de protection en écriture dans les répertoires systèmes dans Windows 3.1/95/98) et a ainsi permis l’exécution de code non fiable, et ceci a fait de lui une cible très facile. […]

Bien qu’il soit possible d’écrire un virus pour des systèmes OSS/FS, leur conception rend la propagation des virus plus difficile.

Il s’avère que les développeurs d’OSS/FS tendent à opter pour des choix de conception limitant les dommages des virus (peut-être, en partie, parce que leur code est sujet à l’inspection et aux commentaires publics).

Par exemple, les OSS/FS ne supportent généralement pas les macros au démarrage ni l’exécution des pièces jointes aux mails pouvant être contrôlés par les pirates.

Les systèmes d’exploitation OSS/FS principaux (tels que GNU/Linux et *BSDs) ont toujours été protégés en l’écriture au niveau des répertoires système.

6. Pérennité

La disponibilité des sources garantit aux utilisateurs la pérennité des logiciels qu’ils utilisent.

L’abandon du support du logiciel par la société éditrice n’est donc pas à craindre.

N’importe qui peut en effet reprendre le code source pour son propre usage selon les limitations de la licence.

Ce qui fait que n’importe quel groupe d’utilisateurs intéressé peut reprendre le travail d’évolution d’un logiciel libre; c’est tout à fait possible et assez courant.

7. Indépendance des vendeurs

En cas de désaccord avec la société qui fournit des développeurs pour ajouter des fonctionnalités à un logiciel, par la disponibilité du code, il est possible grâce à la disponibilité du code de donner ce code à une autre entreprise qui pourra remplacer la précédente.

En effet, le code n’étant pas fermé et donc accessible, il est simple de le récupérer et ainsi d’être indépendant de tout fournisseur.

8. TCO

Le coût total de propriété (TCO) est un paramètre important.

Le fait qu’un produit soit bon marché à l’achat importe peu s’il devient fort coûteux par la suite en mises à jour et frais divers.

En fait, quel que soit le produit utilisé ou plébiscité, il est possible de trouver une étude afin de vérifier s’il possède le plus bas TCO en certaines circonstances.

Evidemment, les firmes Microsoft et Sun 28 fournissent des études prouvant qu’elles possèdent toutes deux le TCO le plus bas.

En bref, le calcul du plus petit TCO dépend de votre environnement et de vos besoins.

Pour déterminer le TCO, vous devez identifier tous les facteurs importants de coût (le modèle du « cost driver ») et estimer leur part.

N’oubliez pas les coûts « cachés » comme les coûts de gestion, les coûts de mise à niveau, le support technique et ainsi de suite.

Les OSS/FS possèdent un certain nombre d’avantages en terme de coût dans diverses catégories qui, dans de nombreux cas, auront comme conséquence un plus petit TCO.

- 1. Les OSS/FS sont meilleur marché en frais d’acquisition mais pas gratuits.

Le « free » dans le terme « free software » se rapporte à la liberté, pas au prix.

Vous continuerez de dépenser de l’argent pour la documentation, le support, la formation, la gestion du système et ainsi de suite, juste comme vous l’auriez fait avec les systèmes propriétaires.

Dans de nombreux cas, les programmes actuels dans les distributions OSS/FS peuvent être acquis gratuitement par téléchargement.

Cependant, nombreux sont ceux qui voudront payer une somme modique à un distributeur pour obtenir des « packages » bien intégrés sur CD-ROM, de la documentation sur papier ainsi qu’un support.

Il n’empêche que les OSS/FS restent moins chers en termes de coûts d’acquisition.

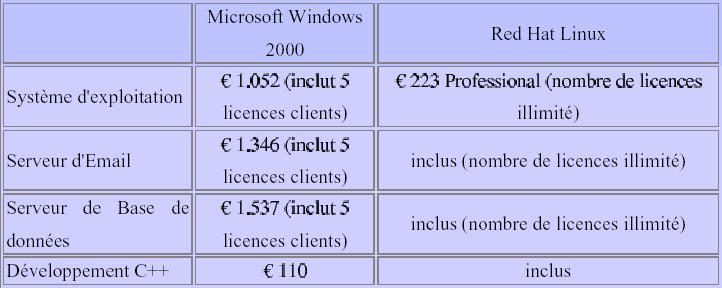

Observons, par exemple, certaines des différences de prix par essais de configuration d’un serveur.

Des objectifs différents impliqueraient des composants différents.

Les prix proviennent de « Redcorp.be » et datent de juillet 2002 (arrondis à l’euro près).

Ce tableau en est un exemple.

Fondamentalement, « Microsoft Windows 2000 » (5 licences clients) présente un coût de 1052 euros.

Leur serveur d’email « Microsoft Exchange » (accès pour 5 clients) coûte 1346 euros, leur serveur de base de données « SQL Server 2000» 1537 euros (avec 5 licences d’accès client), et leur suite de développement Visuel C++ coûte 110 euros.

Red Hat Linux 7.3 (une distribution largement employée de Linux) affiche un coût de 223 euros pour la version professionnelle (les CD d’applications, les divers guides, le CD d’applications spécial serveur et une assistance téléphonique et on-line de 60 jours).

Quoi qu’il en soit, le coût de la Red Hat version professionnelle inclut toutes les fonctionnalités suivantes: web server, serveur d’e-mail, serveur de base de données, C++, et plus.

Un serveur web public avec Windows 2000 et un serveur de base de données pourrait coûter 2589 euros (1052 + 1537) contre 223 euros avec Red Hat Linux, alors qu’un serveur d’Intranet avec Windows 2000 et un serveur d’e-mail pourrait coûter 2398 euros (1052 + 1346) contre 223 euros avec Red Hat Linux.

Le système GNU/Linux est toujours livré avec un nombre illimité de licences.

Le nombre de clients que vous utiliserez réellement dépendra de vos besoins.

Néanmoins, preuve est faite que les produits serveur de Microsoft coûtent des milliers d’euros de plus par serveur que le système équivalent GNU/Linux.

- 2. Les coûts de mise à niveau sont généralement moins importants, y compris à long terme, pour des systèmes OSS/FS.

Par exemple, l’évolution d’un système de Microsoft coûtera généralement environ la moitié de l’achat initial.

Le pire serait que l’utilisateur soit à leur merci au niveau du coût à long terme vu que le fournisseur est le seul à pouvoir assurer la maintenance de ses produits (voir Microsoft Turns the Screws 29).

En revanche, les systèmes GNU/Linux peuvent être téléchargés (gratuitement) ou achetés à nouveau pour disposer de la nouvelle version (généralement pour moins de 250 euros).

En revanche, les systèmes GNU/Linux peuvent être téléchargés (gratuitement) ou achetés à nouveau pour disposer de la nouvelle version (généralement pour moins de 250 euros).

De plus, la mise à niveau simple peut être utilisée sur chaque système n’incluant pas le support technique.

Ceci dit, le support technique peut être concurrencé (situation qui n’est pas possible pour le logiciel propriétaire).

Si vous n’appréciez pas votre fournisseur GNU/Linux (en raison de leur coût, par exemple), vous avez la possibilité de changer.

- 3. Les OSS/FS peuvent souvent être utilisés sur un matériel plus ancien plus efficacement que les systèmes propriétaires.

Il en résulte des coûts plus faibles en matériel avec suppression possible du besoin en nouveau matériel (parce que les machines inutilisées peuvent reprendre une fonction).

Par exemple, les conditions minimales pour Microsoft Windows 2000 Server (selon Microsoft)30 sont un processeur compatible Pentium (133 mégahertz ou supérieur), 128 MB de RAM minimum (avec 256 MB comme « minimum recommandé »), et un disque dur de 2 GB avec au moins 1,0 GB libre.

Selon Red Hat31, Red Hat Linux 7.3 exige au minimum un processeur Pentium (200 mégahertz est recommandé), 32MB en mode texte et 64 MB en mode graphique (96 MB recommandé) et un espace de disque dur de 650MB (2,5 GB recommandés).

- 4. Au fil de l’augmentation du nombre et/ou des performances des systèmes et du matériel, la différence en terme de coûts initiaux et de mise à niveau devient de plus en plus substantielle.

Avec l’augmentation du nombre de serveurs, les solutions propriétaires deviennent plus coûteuses.

D’abord, beaucoup de systèmes propriétaires (Microsoft y compris) vendent des licences par client.

Cela signifie que même si votre matériel peut supporter un nombre plus important de clients, vous devrez payer plus pour utiliser le matériel acheté.

Deuxièmement, si vous désirez utiliser un plus grand nombre d’ordinateurs, vous devrez payer plus de licences au niveau des systèmes propriétaires.

En revanche, en ce qui concerne les distributions GNU/Linux, il est possible d’installer autant de copies que vous le désirez sans aucun surcoût.

Selon Network World Fusion News, Linux est de plus en plus utilisé dans les soins de santé, les finances, les opérations bancaires et dans la vente au détail en raison de ses avantages de coût lors de l’installation d’un grand nombre de sites et de serveurs identiques.

26: http://www.cnn.com2002/tech/internet02252002.security.ideg/index.htmlvnunet.com/news/1116081

27: http://www.attrition.org/mirror/attrition/os.graph.html

28: http://www.sun.com/server/wnkgrouptco

29: http://www.osopignon.com/perl/story/9849.html

30: http://www.microsoft.com/windows2000/server/evaluation

31: http://www.readhat.com/softwar/linux

Selon leurs calculs, pour un déploiement de 2.000 sites, SCO UnixWare coûterait 9 millions de dollars, Windows 8 millions de dollars et Red Hat Linux 180 dollars.